OpenRouter

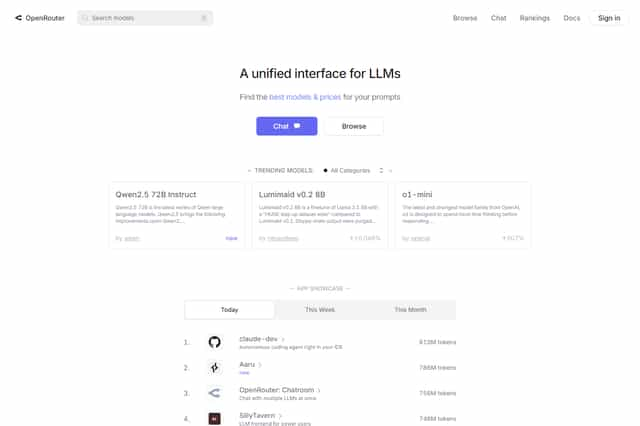

OpenRouter: Plataforma de LMs

OpenRouter.ai é uma plataforma de modelos de linguagem (LM) que fornece acesso a modelos de linguagem de ponta para chat, criação de conteúdo e outras tarefas. O OpenRouter.ai oferece uma ampla variedade de modelos, incluindo Reflection Llama-3.1 70B, Euryale 70B v2.1 e Mistral 7B Instruct v0.2, cada um com suas próprias características e capacidades. A plataforma também fornece ferramentas para personalizar e integrar modelos, como chamada de funções e suporte para Server-Sent Events (SSE) para saída de fluxo. OpenRouter.ai é um serviço de modelo de linguagem versátil e poderoso para desenvolvedores e usuários que desejam aproveitar os poderes da IA de linguagem de última geração.

OpenRouter Introdução

OpenRouter.ai é uma plataforma que fornece diversos modelos de linguagem e ferramentas para ajudar os usuários a utilizar modelos de linguagem avançados para conversar, criar e realizar outras tarefas.

O OpenRouter.ai usa um formato de solicitação e resposta semelhante ao Chat API da OpenAI, mas com algumas pequenas diferenças. Os usuários podem personalizar suas solicitações especificando parâmetros como model, messages, tools e provider. Por exemplo, os usuários podem escolher um modelo específico (por exemplo, mistralai/mixtral-8x7b-instruct ou openai/gpt-3.5-turbo) e especificar o papel e o conteúdo da mensagem (por exemplo, user, assistant ou system).

Se o parâmetro model não for especificado, OpenRouter.ai usará o modelo padrão do usuário ou do cliente. Caso contrário, os usuários precisam escolher um modelo da lista de modelos suportados e incluir o prefixo da organização. O OpenRouter.ai escolhe a GPU mais econômica e com melhor desempenho para lidar com a solicitação, e muda automaticamente para outro provedor ou GPU se houver um código de erro 5xx ou limite de taxa.

O OpenRouter.ai suporta Server-Sent Events (SSE) para saída em tempo real para todos os modelos. Para ativar a saída em tempo real, basta adicionar stream: true no corpo da solicitação. A saída em tempo real pode incluir cargas comment, que devem ser ignoradas.

O OpenRouter.ai também permite a utilização de chamadas a ferramentas. Os usuários podem especificar o parâmetro tools para chamar funções específicas. As ferramentas podem ser do tipo function e conter descrição, nome e parâmetros. Os tipos de ferramentas suportados incluem conteúdo de texto e imagens.

Os usuários podem utilizar OpenRouter.ai configurando um servidor proxy reverso, como Caddy ou Nginx. Ao configurar os cabeçalhos necessários (por exemplo, HTTP-Referer e X-Title), o aplicativo pode ser incluído no ranking de OpenRouter.ai.

O OpenRouter.ai oferece vários modelos de linguagem, como Reflection Llama-3.1 70B, Euryale 70B v2.1 e Mistral 7B Instruct v0.2. Cada um desses modelos tem suas próprias características, como Reflection Llama-3.1 70B, que utiliza o novo Reflection-Tuning para melhorar a precisão da inferência, e Euryale 70B v2.1, que é focado em papéis de atuação criativa.

Os usuários precisam obter uma chave API (API Key) através da plataforma OpenRouter.ai e incluí-la nas suas solicitações. Cabeçalhos opcionais HTTP-Referer e X-Title podem ser usados para exibir informações do aplicativo no ranking do OpenRouter.ai.

Os usuários podem começar a utilizar OpenRouter.ai rapidamente com uma simple solicitação API. Exemplos de código demonstram como realizar solicitações utilizando linguagens como TypeScript, Python e Ruby, e como integrar com a API client da OpenAI.

Em resumo, o OpenRouter.ai fornece uma plataforma flexível e rica em recursos que suporta vários modelos de linguagem e chamadas a ferramentas, adequadas para uma ampla gama de cenários de aplicação.

OpenRouter Característicos

OpenRouter.ai: Uma plataforma de modelos de linguagem

OpenRouter.ai é uma plataforma que oferece uma variedade de modelos de linguagem e ferramentas, com o objetivo de ajudar os usuários a utilizarem modelos de linguagem avançados para conversas, criação de conteúdo e outras tarefas.

Formato de solicitação e resposta

As solicitações e respostas do OpenRouter.ai são semelhantes à API de bate-papo do OpenAI, mas com algumas diferenças. Os usuários podem personalizar a solicitação especificando parâmetros como model, messages, tools e provider . Por exemplo, os usuários podem selecionar um modelo específico (como mistralai/mixtral-8x7b-instruct ou openai/gpt-3.5-turbo), e especificar papéis de mensagem (como user, assistant ou system) e conteúdo🇧🇷

Roteamento de modelos

Se o parâmetro model não for especificado, o OpenRouter.ai usará o modelo padrão do usuário ou do pagador. Caso contrário, o usuário deverá escolher um modelo de uma lista suportada e incluir o prefixo da organização🇧🇷 O OpenRouter.ai escolherá a GPU mais eficiente e com melhor desempenho para tratar a solicitação, e em caso de erro de código 5xx ou limite de taxa, ele irá automaticamente mudar para outro provedor ou GPU🇧🇷

Saída em tempo real

OpenRouter.ai oferece suporte a saída em tempo real de Server-Sent Events (SSE) para todos os modelos. Isso pode ser habilitado incluindo stream: true na solicitação. A saída em tempo real pode incluir cargas comment, que devem ser ignoradas🇧🇷

Parâmetros não padronizados

Se o modelo selecionado não suportar um determinado parâmetro de solicitação (como logit_bias ou top_k), esse parâmetro será ignorado e os parâmetros restantes serão repassados para a API do modelo subjacente.

Chamadas de ferramentas e funções

OpenRouter.ai oferece suporte a chamadas de ferramentas, onde os usuários podem especificar o parâmetro tools para chamar funções específicas. As ferramentas podem ser do tipo function e incluir descrição da função, nome e parâmetros. Tipos de ferramentas suportados incluem conteúdo de texto e de imagem🇧🇷

Configuração de proxy inverso

Os usuários podem usar o OpenRouter.ai, configurando um servidor de proxy reverso como Caddy ou Nginx. Ao configurar os cabeçalhos necessários (como HTTP-Referer e X-Title), aplicativos podem ser incluídos na classificação do OpenRouter.ai.

Seleção de modelo

OpenRouter.ai oferece vários modelos de linguagem, incluindo Reflection Llama-3.1 70B, Euryale 70B v2.1 e Mistral 7B Instruct v0.2. Cada modelo possui características únicas. Por exemplo, Reflection Llama-3.1 70B utiliza a nova técnica de Reflection-Tuning para aumentar a precisão da inferência, e Euryale 70B v2.1 se concentra em funções de interpretação criativa.

Chave API e configuração

Os usuários precisam recuperar uma chave API através da plataforma OpenRouter.ai e incluí-la nas solicitações. Os cabeçalhos HTTP-Referer e X-Title opcionais podem ser usados para exibir informações do aplicativo na classificação OpenRouter.ai.

Começando rapidamente

Os usuários podem começar rápidamente a usar o OpenRouter.ai por meio de uma solicitação de API simples. Os exemplos de código mostram como efetuar solicitações usando linguagens como TypeScript, Python ou Ruby e como integrá-los ao cliente API do OpenAI.

OpenRouter.ai fornece uma plataforma flexível e rica em recursos, que suporta uma variedade de modelos de linguagem e chamadas de ferramentas, aplicações de dados da linguagem, conversas inteligentes, geração de conteúdo e muito mais.

OpenRouter Perguntas frequentes

O que é OpenRouter?

OpenRouter é uma plataforma que fornece uma variedade de modelos de linguagem e ferramentas, ajudando os usuários a aproveitar os modelos de linguagem de ponta para bate-papos, criação e outras tarefas.

Como OpenRouter funciona?

OpenRouter funciona como um serviço de API, permitindo que os usuários enviem solicitações e recebam respostas usando modelos de linguagem. Você pode integrar o OpenRouter em seus próprios aplicativos ou usá-lo diretamente por meio da sua interface.

Quais são os recursos do OpenRouter?

OpenRouter oferece uma série de recursos, incluindo:

- Modelagem de seleção: Escolha entre uma variedade de modelos de linguagem disponíveis, como

mistralai/mixtral-8x7b-instructouopenai/gpt-3.5-turbo. - Gerenciamento de custos: Você pode optar por utilizar o modelo padrão ou escolher um modelo específico, e o OpenRouter automaticamente seleciona a GPU mais eficiente para lidar com a sua solicitação.

- Stream de saída: OpenRouter suporta stream de saída, permitindo que você obtenha as respostas do modelo de maneira incremental, recebendo as informações gradualmente.

- Chamadas de função: Você pode integrar funções personalizadas em suas solicitações, permitindo que você utilize o OpenRouter para executar ações, como coletar dados ou interagir com APIs.

Quais são as vantagens de usar OpenRouter?

- Facilidade de uso: OpenRouter é simples de usar e se integra facilmente a diversos projetos, incluindo aplicativos web e de desktop.

- Flexibilidade: Você pode configurar, personalizar e estender o OpenRouter para atender às suas necessidades específicas.

- Escalabilidade: O OpenRouter pode lidar com volumes crescentes de solicitações, tornando-o ideal para aplicações complexas e grandes volumes de dados.

Como posso começar a usar OpenRouter?

Para usar o OpenRouter, você precisará adquirir uma chave de API. Você pode obter essa chave na plataforma do OpenRouter. Depois de ter a chave, você pode começar a fazer solicitações à API, usando a linguagem e a biblioteca de sua preferência.

Quais são as integrações do OpenRouter?

OpenRouter pode ser combinado com diversas ferramentas e plataformas populares. Você pode verificar os exemplos disponíveis no site para obter mais informações.

Existe alguma documentação sobre OpenRouter?

Sim, o OpenRouter possui uma documentação abrangente que fornece informações detalhadas sobre todos os aspectos da plataforma, desde os conceitos básicos até os recursos avançados. Você pode encontrar a documentação no site do OpenRouter.