OpenRouter

OpenRouter - Plateforme de Langage pour la Communication & la Création

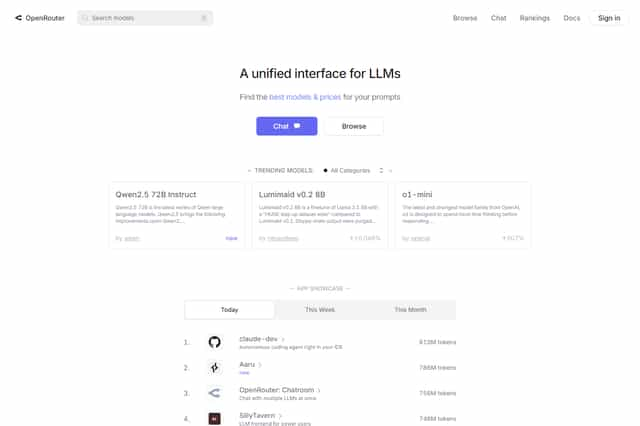

OpenRouter.ai est une plateforme qui fournit diverses API ainsi que des modèles de langage et des outils pour simplifier l'utilisation de modèles de langage avancés. En tant qu'utilisateur, vous pouvez communiquer avec des modèles comme Mistralai/mixtral-8x7b-instruct ou openai/gpt-3.5-turbo. Les modèles et les outils peuvent être utilisés pour des tâches comme le chat, la création de contenu et d'autres scénarios. OpenRouter offre une variété de fonctionnalités, y compris le routage de modèle, le streaming de sortie, les appels de fonctions et les outils. Vous pouvez également configurer un serveur proxy inverse pour intégrer votre application OpenRouter.

OpenRouter Introduction

OpenRouter.ai est une plateforme permettant d'accéder à des modèles de langage variés et à divers outils. Il permet aux utilisateurs de tirer profit de modèles de langage avancés pour le chat, la création de contenu et d'autres tâches. OpenRouter.ai offre une interface simple pour interagir avec les modèles de langage, en acceptant les demandes et en renvoyant des réponses dans un format similaire à celui de l'API Chat d'OpenAI. Le format des requêtes et des réponses est très similaire à celui de l'API Chat d'OpenAI, mais avec quelques petites différences.

Les utilisateurs peuvent personnaliser leurs requêtes en spécifiant des paramètres comme model, messages, tools et provider. Par exemple, les utilisateurs peuvent choisir un modèle spécifique (comme mistralai/mixtral-8x7b-instruct ou openai/gpt-3.5-turbo). Ils peuvent également préciser le rôle des messages (comme user, assistant ou system) et leur contenu. Si aucun modèle n'est spécifié, OpenRouter.ai utilise le modèle par défaut de l'utilisateur ou de son abonné. Sinon, les utilisateurs doivent choisir un modèle dans la liste des modèles pris en charge en incluant le préfixe de l'organisation.

OpenRouter.ai sélectionne le GPU le plus rentable et le plus performant pour traiter la requête. Il bascule automatiquement vers un autre fournisseur ou un autre GPU en cas d'erreur de code 5xx ou de limitation du taux, optimisant ainsi les performances et la fiabilité. De plus, OpenRouter.ai prend en charge les appels de fonctions, permettant aux utilisateurs de spécifier le paramètre tools pour appeler des fonctions spécifiques. Les outils peuvent être de type function avec une description, un nom et des paramètres. Les types d'outils pris en charge incluent les contenus textuels et les contenus image. OpenRouter.ai prend en charge la sortie en continu (Server-Sent Events - SSE) pour tous les modèles. Les utilisateurs peuvent activer la sortie en continu en ajoutant stream: true au corps de la requête. La sortie en continu peut inclure des charges "comment" qui doivent être ignorées. Les utilisateurs peuvent configurer un serveur proxy inverse, tel que Caddy ou Nginx, pour utiliser OpenRouter.ai. En définissant les en-têtes nécessaires (comme HTTP-Referer et X-Title), les applications peuvent être incluses dans le classement d'OpenRouter.ai. 🤯

OpenRouter Caractéristiques

OpenRouter.ai : Une plateforme de modèle linguistique

OpenRouter.ai est une plateforme qui permet aux utilisateurs d'accéder à une variété de modèles linguistiques et d'outils pour alimenter les applications de chatbot, de création de contenu et d'autres tâches.

OpenRouter : Format des requêtes et des réponses

Le format des requêtes et des réponses OpenRouter.ai est similaire à l'API Chat d'OpenAI, mais avec quelques différences. Les utilisateurs peuvent personnaliser les requêtes en spécifiant des paramètres comme model, messages, tools, et provider. Par exemple, les utilisateurs peuvent choisir un modèle spécifique (par exemple, mistralai/mixtral-8x7b-instruct ou openai/gpt-3.5-turbo) et spécifier les rôles de message (user, assistant ou system) et le contenu.

OpenRouter : Routage des modèles

Si le paramètre model n'est pas spécifié, OpenRouter.ai utilisera le modèle par défaut de l'utilisateur ou du payeur. Sinon, l'utilisateur devra sélectionner un modèle dans la liste des modèles pris en charge, y compris le préfixe de l'organisation. OpenRouter.ai sélectionnera le GPU le plus rentable et le plus performant pour traiter la demande, et basculera automatiquement vers un autre fournisseur ou GPU en cas d'erreur 5xx ou de limitation de vitesse.

OpenRouter : Sortie en continu

OpenRouter.ai prend en charge les flux de sortie Server-Sent Events (SSE) pour tous les modèles. Pour activer la sortie en continu, ajoutez simplement stream: true dans le corps de la demande. Les flux de sortie peuvent inclure des charges utiles de "commentaires" qui doivent être ignorées.

OpenRouter : Paramètres non standard

Si le modèle sélectionné ne prend pas en charge un certain paramètre de demande (par exemple, logit_bias ou top_k), le paramètre sera ignoré et les autres paramètres seront transmis à l'API du modèle sous-jacent.

OpenRouter : Appels d'outils et fonctions

OpenRouter.ai prend en charge les appels d'outils, les utilisateurs peuvent spécifier le paramètre tools pour appeler des fonctions spécifiques. Les outils peuvent être de type function, comprenant une description de la fonction, un nom et des paramètres. Les types d'outils pris en charge incluent le contenu textuel et le contenu image.

OpenRouter : Configuration du proxy inverse

Les utilisateurs peuvent configurer OpenRouter.ai via un serveur proxy inverse comme Caddy ou Nginx. En définissant les en-têtes nécessaires (par exemple, HTTP-Referer et X-Title), les applications peuvent être incluses dans le classement OpenRouter.ai.

OpenRouter : Sélection du modèle

OpenRouter.ai offre une variété de modèles linguistiques, y compris Reflection Llama-3.1 70B, Euryale 70B v2.1 et Mistral 7B Instruct v0.2. Ces modèles ont chacun des caractéristiques uniques : par exemple, Reflection Llama-3.1 70B utilise la nouvelle technologie Reflection-Tuning pour améliorer la précision de l'inférence, tandis qu'Euryale 70B v2.1 se concentre sur les scénarios de jeu de rôle créatifs.

OpenRouter : Clé API et configuration

Les utilisateurs doivent obtenir une clé API via la plateforme OpenRouter.ai et l'inclure dans les requêtes. Les en-têtes facultatifs HTTP-Referer et X-Title peuvent être utilisés pour afficher les informations de l'application dans le classement OpenRouter.ai.

OpenRouter : Prise en main rapide

Les utilisateurs peuvent commencer à utiliser OpenRouter.ai rapidement avec une simple requête API. Des exemples de code montrent comment effectuer des requêtes en utilisant des langages comme TypeScript, Python ou Ruby, et comment intégrer l'API client OpenAI.

OpenRouter : Résumé

OpenRouter.ai fournit une plateforme flexible et riche en fonctionnalités, qui prend en charge une variété de modèles linguistiques et d'appels d'outils, adaptés à une large gamme de cas d'utilisation.

OpenRouter Questions fréquemment posées

Qu'est-ce qu'OpenRouter ?

OpenRouter est un outil qui permet de gérer les requêtes et les réponses des modèles de langage.

Comment OpenRouter fonctionne-t-il ?

OpenRouter est une plateforme qui fournit une variété de modèles de langage et d'outils. Cette plateforme facilite l'utilisation de ces derniers pour des tâches telles que la création de conversations, l'écriture de textes et bien d'autres.

Quelle est la différence entre OpenRouter et OpenAI ?

OpenRouter est similaire à l'API de conversation d'OpenAI mais avec quelques différences. OpenRouter permet, notamment, aux utilisateurs de personnaliser leurs requêtes avec des paramètres tels que model, messages, tools et provider.

Quels modèles OpenRouter prend-il en charge ?

OpenRouter prend en charge un large éventail de modèles de langage, notamment Reflection Llama-3.1 70B, Euryale 70B v2.1 et Mistral 7B Instruct v0.2.

Puis-je utiliser OpenRouter avec des outils ?

Oui, OpenRouter prend en charge les appels de fonctions et les outils. Les outils peuvent être de type function et inclure une description de fonction, un nom et des paramètres.

Quels sont les avantages d'utiliser OpenRouter ?

OpenRouter offre plusieurs avantages, notamment la possibilité de choisir entre un large éventail de modèles de langage, la prise en charge des appels d'outils et la simplification de la gestion des requêtes et des réponses.

Comment puis-je commencer à utiliser OpenRouter ?

Pour commencer à utiliser OpenRouter, vous devez obtenir une clé API sur la plateforme OpenRouter.ai et l'inclure dans vos requêtes.

Quelles sont les implications éthiques de l'utilisation d'OpenRouter ?

Il est important de noter que tous les modèles de langage, y compris ceux utilisés par OpenRouter, sont susceptibles de présenter des biais et de générer des contenus potentiellement nuisibles. Il est important d’utiliser ces outils de manière responsable et consciente des implications éthiques.