OpenRouter

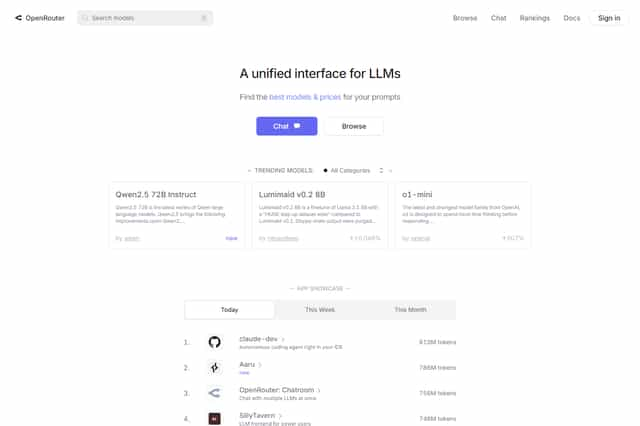

OpenRouter.ai:多様な言語モデルとツールを活用できるプラットフォーム

OpenRouter.aiは、OpenAIのChat APIとよく似たリクエストとレスポンスのフォーマットを採用しています。OpenRouter.aiを利用すると、様々な言語モデルから自由に選択して、Chat APIを用いたアプリケーションの開発をより柔軟に行うことが可能です。例えば、`model`、`messages`、`tools`、`provider`といったパラメータを設定することで、ユーザーはニーズに合った処理を実行できます。OpenRouter.aiのAPIを使うと、特定のモデル(例えば`mistralai/mixtral-8x7b-instruct`や`openai/gpt-3.5-turbo`)、メッセージの役割(`user`、`assistant`、`system`など)、コンテンツを指定できます。OpenRouter.aiを使用すると、ユーザーは事前に選択したモデルを使用するか、OpenRouter.aiが自動的に選択したモデルを使用することができます。さらに、APIは流式出力とツール呼び出しをサポートし、アプリケーション開発者に柔軟性と機能性をもたらします。OpenRouter.aiは、豊富な機能と柔軟性を備えたプラットフォームであり、様々な用途のChat APIアプリケーション開発をシンプルかつ効率的に行うことを可能にします。

OpenRouter 導入

OpenRouter.aiは、さまざまな言語モデルとツールを提供するプラットフォームであり、ユーザーが高度な言語モデルを使用してチャット、創作、その他のタスクを実行できるようにすることを目的としています。OpenRouter.aiは、OpenAIのチャットAPIと非常によく似たリクエストとレスポンスの形式を採用していますが、いくつかの小さな違いがあります。ユーザーは、model、messages、tools、providerといったパラメーターを指定することで、リクエストをカスタマイズできます。例えば、ユーザーは特定のモデル(例:mistralai/mixtral-8x7b-instructやopenai/gpt-3.5-turbo)を選択し、メッセージの役割(例:user、assistant、system)と内容を指定できます。

OpenRouter.aiは、ユーザーまたは有料会員のデフォルトモデルを使用します。ただし、modelパラメーターが指定されている場合は、ユーザーはサポートされているモデルのリストからモデルを選択し、組織のプレフィックスを含める必要があります。OpenRouter.aiは、最もコスト効率が高く、パフォーマンスが優れたGPUを選択して、リクエストを処理します。5xxエラーコードまたはレート制限が発生した場合、OpenRouter.aiは自動的に他のプロバイダーまたはGPUに切り替えます。

OpenRouter.aiは、すべてのモデルでサーバー・セント・イベント(SSE)のストリーミング出力をサポートしています。ストリーミング出力を有効にするには、リクエスト本文にstream: trueを追加するだけです。ストリーミング出力には、「comment」という負荷が含まれる場合がありますが、これらの負荷は無視する必要があります。ユーザーはtoolsパラメーターを指定することで、特定の関数を呼び出すことができます。ツールはfunction型にすることができ、関数説明、名前、パラメーターを含みます。サポートされているツールタイプには、テキストコンテンツと画像コンテンツが含まれます。

OpenRouter 特徴

OpenRouterとは

OpenRouterは、ユーザーがさまざまな言語モデルを活用して、チャットやコンテンツ作成など、さまざまなタスクを実行できるプラットフォームです。OpenRouterは、OpenAIのChat APIに似ていますが、いくつかの機能が追加されています。

OpenRouterの特徴

柔軟なモデル選択

OpenRouterでは、Mistralai/mixtral-8x7b-instructやopenai/gpt-3.5-turboなど、多くの言語モデルの中から選択できます。モデルを選択することで、それぞれのモデルの強みを活かしたタスクを実行できます。

モデル自動ルーティング

モデルを指定しない場合は、OpenRouterはユーザーのデフォルトモデルを使用します。また、OpenRouterは、最も費用対効果の高いGPUを選択して、リクエストを処理します。もし、5xxエラーが発生した場合、OpenRouterは自動的に別のプロバイダーやGPUに切り替えます。

流式出力

OpenRouterは、Server-Sent Events(SSE)を使用して、すべてのモデルで流式出力をサポートしています。 stream: trueをリクエスト本文に追加することで、流式出力を有効にすることができます。

工具と関数呼び出し

OpenRouterは、tools パラメータを使用して、特定の関数を呼び出すことができます。ツールは、function タイプで、関数記述、名前、パラメータが含まれています。 OpenRouterは、テキストコンテンツや画像コンテンツを含む、さまざまなタイプのツールをサポートしています。

反向プロキシの設定

OpenRouterは、CaddyやNginxなどの反向プロキシサーバを通じて使用できます。OpenRouterは、必要なヘッダー(HTTP-Referer や X-Title など)を設定することで、OpenRouterのランキングにアプリケーションを追加できます。

モデルの多様性

OpenRouterには、Reflection Llama-3.1 70B、Euryale 70B v2.1、Mistral 7B Instruct v0.2など、さまざまな言語モデルが用意されています。これらのモデルは、それぞれの特性を持っています。例えば、Reflection Llama-3.1 70Bは、新しいReflection-Tuning技術を使用して、推論の精度を向上させています。Euryale 70B v2.1は、創造的なロールプレイングに焦点を当てています。

簡単な使用

OpenRouterは、シンプルなAPIリクエストを通じて使用することができます。TypeScript、Python、Rubyなどの言語を使用してAPIリクエストを作成し、OpenAIのクライアントAPIを統合することができます。

まとめ

OpenRouterは、さまざまな言語モデルとツールをサポートし、幅広いアプリケーションシナリオに対応できる柔軟で機能豊富なプラットフォームです。

OpenRouter よくある質問

OpenRouter.ai とは?

OpenRouter.ai は、様々な言語モデルとツールを提供するプラットフォームで、ユーザーが様々な高度な言語モデルを使ってチャット、創作、その他のタスクを実行できるようにするものです。

OpenRouter.ai はどのように OpenAI の Chat API と似ていますか?

OpenRouter.ai のリクエストとレスポンスのフォーマットは、OpenAI の Chat API と非常によく似ていますが、いくつかの小さな違いがあります。ユーザーは model、messages、tools、provider などのパラメーターを指定してリクエストをカスタマイズできます。例えば、ユーザーは特定のモデル(例えば mistralai/mixtral-8x7b-instruct や openai/gpt-3.5-turbo)を選択したり、メッセージの役割(例えば user、assistant、system)とその内容を指定したりできます。

OpenRouter.ai のモデルルーティングについて教えてください。

model パラメーターが指定されていない場合、OpenRouter.ai はユーザーまたは有料ユーザーのデフォルトモデルを使用します。そうでない場合、ユーザーはサポートされているモデルリストからモデルを選択し、組織プレフィックスを含める必要があります。OpenRouter.ai は、最もコスト効率が高く、パフォーマンスが最適な GPU を選択してリクエストを処理します。5xx エラーコードが発生したり、レート制限が発生したりした場合、他のプロバイダーまたは GPU に自動的に切り替えます。

OpenRouter.ai はどんなツールや機能をサポートしていますか?

OpenRouter.ai は、ツール呼び出しをサポートしており、ユーザーは tools パラメーターを指定して特定の関数を呼び出すことができます。ツールは function タイプにすることができ、関数記述、名前、パラメーターを含みます。サポートされているツールタイプには、テキストコンテンツと画像コンテンツがあります。